深度学习记录(三):了解神经网络模型(结构、原理)

神经网络

听到神经网络,总是被各种各样的称呼迷惑半天,什么CNN、RNN、GAN、NN等等,下面准备从各个神经网络入手,了解他们的网络结构及工作原理。

先验知识

赫布型学习

1949年,心理学家唐纳德·赫布在《The Organization of Behavior》论文中描述了神经元学习法则,这是一个神经科学理论,解释了学习过程中脑神经元发生的变化,描述了突触可塑性原理,即突触前神经元向突触后神经元的持续重复的刺激,可以导致突触传递效能的增加。

这一理论可以表述为:

我们可以假定,反射活动的持续与重复会导致神经元稳定性的持久性提升……当神经元A的轴突与神经元B很近并参与了对B的重复持续的兴奋时,这两个神经元或其中一个便会发生某些生长过程或代谢变化,致使A作为能使B兴奋的细胞之一,它的效能增强了。

- 神经元”A”的激发必须在神经元”B”之先,而不能同时激发——>突触可塑性需要一定的时间延迟

- 对神经元的重复刺激,使得神经元之间的突触强度增加

感知机

我们知道人工智能的任务是模拟人的智能做出类似的决策等,那么在早期人工智能刚兴起时,科学家就想到了“能否构造模拟人脑的模型呢?”,人脑有数以亿计的神经元组成,当人接收到外界刺激时,生成的电信号在各个神经元细胞直接传递,然后人会得到相应的信息,继而作出反应,神经元传递信息的这一过程似乎与计算机的工作原理类似,所以最初的神经网络从单个神经元出发,研究这一基本单位,确认如何模拟工作。

因而有了最基本的**感知机 (英语:Perceptron,一种神经元模型)**:

弗兰克·罗森布拉特在1957年就职于康奈尔航空实验室(Cornell Aeronautical Laboratory)时所发明的一种人工神经网路。它可以被视为一种最简单形式的前馈神经网路,是一种二元线性分类器,在人工神经网络领域,它也被指为单层的人工神经网络。但是它的本质缺陷是不能处理线性不可分问题。

——来自维基百科

工作原理:其输入为实例的特征向量,输出为实例的类别。

感知器的取值为+1和-1的二值,感知机对应于输入空间中将实例划分为正负两类分离超平面(超平面是指在N维图形内部的N-1维图形,如二维平面中的一维直线、三维空间中的二维平面),属于判别模型,

感知机学习旨在求出将训练数据进行线性划分的分离超平面——>导入基于误分类的损失函数——>利用梯度下降法进行损失函数极小化——>求出感知机模型。

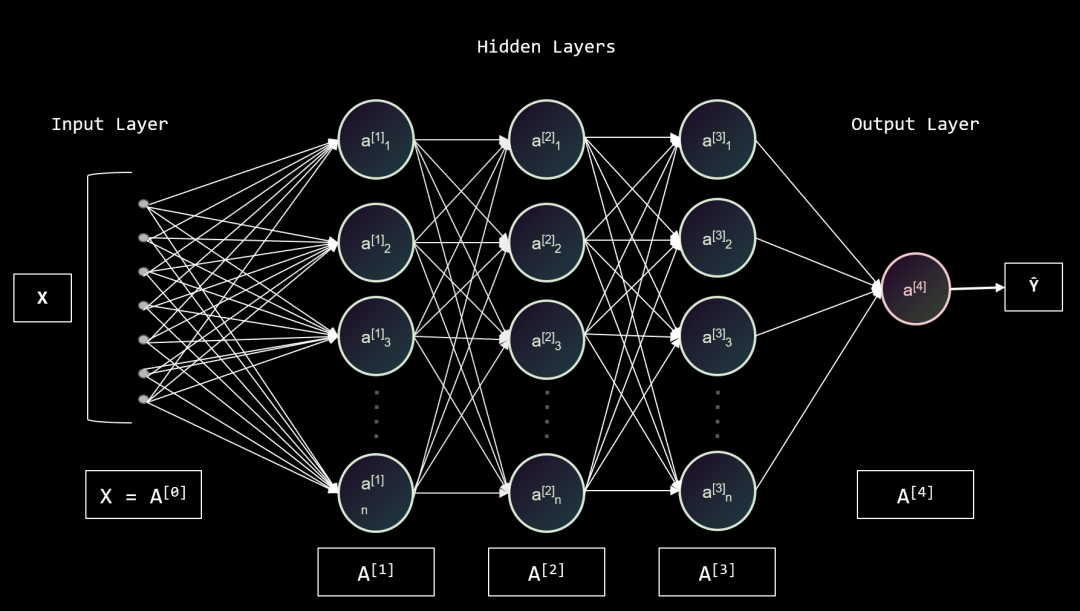

前馈神经网络(Feedforward neural network,FNN)

前馈卷积神经网络

- 标题: 深度学习记录(三):了解神经网络模型(结构、原理)

- 作者: 狮子阿儒

- 创建于 : 2023-05-10 22:40:21

- 更新于 : 2024-03-03 21:32:57

- 链接: https://c200108.github.io/blog/2023/05/10/深度学习记录(三):了解神经网络模型(结构、原理)/

- 版权声明: 本文章采用 CC BY-NC-SA 4.0 进行许可。